Koniec prawa Moore’a odmienia branżę

Skalowanie procesu CMOS – stan obecny i przyszłość

Oczekiwany koniec prawa Moore’a doprowadzi do istotnych zmian w branży półprzewodnikowej oraz komputerowej – do takiego wniosku doszedł panel ekspertów zgromadzonych podczas 50-tej rocznicy jubileuszu nagrody Turinga.

Pewne technologie krzemowe, rozwiązania systemowe i oprogramowanie będą nadal się rozwijać, jednak nie wszystkie w równym tempie. Bez prostej alternatywy dla skalowania procesu CMOS przemysł półprzewodnikowy i systemy elektroniczne mogą przyjąć postać pionowych, zamkniętych standardów – konkludują eksperci.

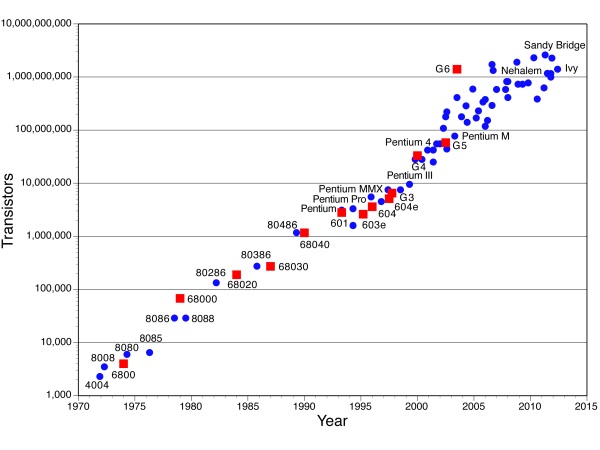

„Prawo Moore’a stanowi, że gęstość upakowania tranzystorów podwaja się co 18 miesięcy. Udało nam się utrzymać ten trend przed 25 lat, ale zaczął on zwalniać do okresu 2-3 lat w okolicy roku 2000-2005. Ostatnio obserwujemy podwojenie co około cztery lata. Zbliżamy się zatem do końca rozwoju znanej nam dotychczas technologii półprzewodnikowej.” – oznajmił John Hennessy, były rektor Uniwersytetu Stanforda i autor książki na temat mikroprocesorów.

Powiązanym zjawiskiem jest prawo Dennarda – mówi ono, że pobór mocy pozostaje w stałej proporcji wraz ze zmniejszaniem się tranzystorów. ”Przestało ono funkcjonować 10-15 lat temu, wobec czego przemysł szybko przeniósł się na procesory wielordzeniowe.” – dodał Henessy.

„Prawo Moore’a jest w rzeczywistości obserwacją zjawisk ekonomicznych, a nie prawem fizyki. Pytanie brzmi, czy znajdziemy inny aspekt fizyki, który ma taką samą stopę zwrotu inwestycji, jak układy CMOS?” – wyjaśnia Margaret Martonosi, specjalistka ds. systemów na Uniwersytecie Princeton.

„Prawo Moore’a odniesione do szybkości zmiany gęstości upakowania przestało obowiązywać. Jesteśmy już poza zakresem możliwych do przewidzenia zmian, a za kilka generacji spotkamy się z nieuchronnymi ograniczeniami prawa fizyki.” – dodał Doug Burger, inżynier pracujący nad akceleracją FPGA na potrzeby usługi chmurowej Microsoft Azure. Dodaje: „Wyczerpaliśmy korzyści wynikające z prawa Moore’a. Wkraczamy w niepewne i nieprzewidywalne czasy – ale to właśnie jest najbardziej interesujące.”

„Sądzę, że wciąż pozostało nam kilka lat skalowania układów CMOS.” – Oznajmił Norm Jouppi, projektant mikroprocesorów z dużym stażem i kierownik zespołu odpowiedzialnego za akcelerator TPU Google. – „W niektórych zastosowaniach będzie można zaobserwować przyspieszenie jeszcze przez dekadę, ale w innych wzrost będzie wolniejszy.”

Joupii twierdzi, że branża usilnie stara się zanegować koniec prawa Moore’a, podobnie jak sprzedawca ze skeczu Monthy Pythona, który twierdzi, że papuga „nie jest martwa, tylko odpoczywa”.

Koniec pamięci DRAM, początek systemów hybrydowych

Pamięci DRAM mogą być jednymi z pierwszym podstawowych komponentów, które napotkają ograniczenia – podejrzewa Henessy. Burger zasugerował, że w wyniku tego powstaną „niezrównoważone architektury systemów – wymagające ogromnej pracy od projektantów tych systemów”.

„Pionowo ułożone kości NAND są w stanie zapełnić lukę pozostawioną przez DRAM, ale wymagają dużych inwestycji.” – komentuje Jouppi.

„Cokolwiek nastąpi, po upadku prawa Moore’a będziemy świadkami transformacji. Za 20 lat branża zmieni się nie do poznania.” – przewiduje Burger.

Fot. 1. Doug Burger z Microsoftu był pionierem teorii grafów na Uniwersytecie w Texasie (źródło: ACM)

Rosnące koszty fabryk prowadzą do historycznej konsolidacji producentów układów scalonych, jednak „dopóki mamy na rynku 3 lub 4 silnych graczy, dopóty będzie trwać silna konkurencja.” – przewiduje Jouppi, zaznaczając przy tym: „Silnym czynnikiem symulującym jest popyt na urządzenia iPhone.”

Zarówno Burger, jak i Juppi przewidują nadejście „architektur związanych z określonymi obszarami”, które będą optymalizowały wydajność zgodnie z wymaganiami konkretnych rynków. Burger opisuje ten trend jako „okropny”, prowadzący do powstania „systemów-potworków… jednak rynek jest wystarczająco duży, aby pomieścić takie rozwiązania”. – dodaje Jouppi.

„Architektury związane z konkretnymi obszarami są jak dzieła sztuki – te, których używaliśmy do tej pory, bardzo kreatywnie wykorzystują tranzystory.” – komentuje Jouppi.

Hennessy zastanawia się, czy przemysł komputerowy nie powróci do czasów firm o pionowej strukturze, które projektują wszystko od układów krzemowych do aplikacji. Apple podąża w tym kierunku, a Google najwidoczniej je naśladuje. „Mimo to, pojawiają się również nowe architektury, niektóre projektowane przez dostawców układów półprzewodnikowych, a inne – przez dostawców usług chmurowych.” – kontruje Jouppi.

Opinie panelistów były podzielone w kwestii pojawienia się nowych producentów procesorów w przeszłości, ponieważ do tej pory rynek skupił się wokół kilku list rozkazowych. „Do projektowania układów scalonych potrzeba bardzo specjalistycznych umiejętności, zatem konsolidacja firm projektujących procesory w sposób naturalny przynosi korzyści.” – tłumaczy Hennessy.

Poszukiwane: nowe interfejsy i aplikacje kwantowe

Powolny upadek prawa Moore’a już podważa podstawy warstwy abstrakcji, która separowała programistów od zmian w układach scalonych – model programowy procesora (ISA). Potrzebne są nowe, bardziej uogólnione interfejsy, być może obsługujące wiele segmentów rynku. Jednak nie jest jasne, jak właściwie miałyby wyglądać.

Dzięki modelom programowym programiści mogą „otrzymywać darmowe ulepszenia przy względnie małych zmianach. Jednak współczesne smartfony często wykorzystują nawet 6 różnych modeli ISA, a połowę układu SoC stanowi akcelerator, którego model programowy szybko się dezaktualizuje.” – tłumaczy Martonosi z uniwersytetu w Princeton.

Nowe oprogramowanie szkieletowe oraz biblioteki pomagają uzupełnić tą lukę, lecz tworzone w ten sposób systemy są „trudne do weryfikacji i zabezpieczenia… ta sytuacja będzie się pogarszać.” – prognozuje Martonosi. Jeśli systemy związane z konkretnym rynkiem zaczną rozwijać własne interfejsy,wystąpi potrzeba opracowania nowych procesów projektowania. Będzie to również wymagać od inżynierów możliwości pracy „na niższych i i wyższych warstwach systemu”, dodaje.

„Rodzaje obciążeń spotykane w systemach chmurowych wciąż są bardzo zróżnicowane.” – Zauważa Burger związany z działem Microsoft ds. systemów chmurowych. Dostawcy usług chmurowych mają miliony klientów, a „nawet duże systemy wykorzystują 1-2 procent naszych serwerów i zmieniają się co tydzień lub co miesiąc – to zbyt często nawet dla FPGA.” – dodaje Burger. Zauważa też, że nawet tzw. „układy programowalne” wciąż pozostają zbyt trudne w programowaniu.

Odejście od prawa Moore’a napędza potrzebę opracowania bardziej wydajnego oprogramowania i procesorów ogólnego przeznaczenia – twierdzą paneliści.

„Mam nadzieję, że uda nam się udoskonalić oprogramowanie oraz sprzęt. Obie te warstwy są niedopracowane i zachowają potencjał do dalszych ulepszeń przez długi czas.” – twierdzi Jouppi.

„Co prawda nie zastąpi to prawa Moore’a, ale w obszarze aplikacji, algorytmów i rozwiązań sprzętowych pozostaje miejsce na udoskonalenia.” – podsumował Lampson, znany główne jako jeden z wynalazców Alto, nowatorskiego systemu z okresu rozwoju komputerów PC.

„Nie ma jednego rozwiązania, które mogłoby zastąpić prawo Moore’a w dłuższym okresie, jednak pewne nadzieje dają komputery kwantowe.” – twierdzi Martonosi, która przez lata pracowała nad praktycznymi rozwiązaniami z tej dziedziny. – „Z punktu widzenia fizyki widzimy, że systemy kwantowe są naprawdę blisko urzeczywistnienia. Maszyna o pojemności 50 – 100 qubitów mogłaby pojawić się w ciągu roku lub dwóch. Niektórzy twierdzą, że są w stanie napisać programy dla tych maszyn, które będą w stanie prześcignąć klasyczne systemy.”

Zła wiadomość jest taka, że jest znanych tylko kilka ograniczonych aplikacji dla takich systemów. „Istnieje duża różnica między liczbą qubitów potrzebnych do realizacji wielu popularnych aplikacji, a liczbą, którą możemy umieścić w działających systemach w przewidywalnej przyszłości. Nie jest oczywiste, kto mógłby sponsorować systemy z tysiącami qubitów i odpowiednie dla nich aplikacje.” – dodała.

„Zbudujemy komputery kwantowe, ale czy uda nam się rozwiązań istotne problemy im towarzyszące? To jest zdanie na przyszłość.” – skomentował Burger, wspominając o jeszcze bardziej futurystycznych projektach programowalnych układów biologicznych opartych na łańcuchach protein.

Caroline Pannier – nowa dyrektorka targów electronica – analizuje sytuację gospodarczą branży i przedstawia wyniki

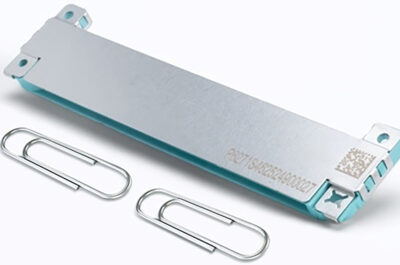

Caroline Pannier – nowa dyrektorka targów electronica – analizuje sytuację gospodarczą branży i przedstawia wyniki  Konstrukcja Ventiva Zoned Cooling™ – ukierunkowane chłodzenie powietrza dla urządzeń AI Edge

Konstrukcja Ventiva Zoned Cooling™ – ukierunkowane chłodzenie powietrza dla urządzeń AI Edge  Komunikacja dalekiego zasięgu oparta na technologii Qualcomm dla robotyki i dronów

Komunikacja dalekiego zasięgu oparta na technologii Qualcomm dla robotyki i dronów