Jaka przyszłość czeka Wi-Fi?

Co jest ważne dla klientów?

W przypadku usług Wi-Fi, klientów interesują trzy podstawowe cechy:

Oczywiście występują też inne czynniki, takie jak łatwość nawiązania połączenia czy łatwość instalacji. W pierwszym przypadku nastąpił znaczny postęp, a łatwość instalacji poprawia się dzięki rozproszonym urządzeniom dostępowym Wi-Fi (które w pewien sposób poprawiają również zasięg sieci). Istnieje też bardziej skomplikowany problem eliminacji interferencji wywoływanych przez transmisje sąsiadów, co może (lecz nie musi) wpływać na spowolnienie sieci Wi-Fi.

Pojemność

Choć może się wydawać, że najważniejszą kwestię stanowi wysoka przepustowość, przyjrzymy się w pierwszej kolejności zagadnieniu pojemności – możliwości wykorzystania sieci Wi-Fi przez wielu użytkowników jednocześnie.

W dzisiejszych czasach wiele osób posiada router, a każdy użytkownik podłączający się do tego routera wykorzystuje ten sam kanał Wi-Fi. To oznacza, że użytkownicy współdzielą to samo pasmo i tę samą przepustowość. W przypadku stosowania retransmisji, pasmo jest dzielone w jeszcze większym stopniu – repeater dokonuje retransmisji w tym samym momencie, gdy użytkownik komunikuje się z repeaterem. To w praktyce podwaja zajętość tego samego kanału.

W opisywanej sytuacji rozproszona sieć Wi-Fi przynosi duże korzyści. W takiej sieci każdy węzeł może komunikować się z użytkownikiem końcowym we własnym paśmie częstotliwości i równocześnie przy wykorzystaniu innego pasma komunikować się z routerem podłączonym do Internetu.

Aby zobrazować ten scenariusz, zauważmy, że pierwsza implementacja Wi-Fi wykorzystywała w praktyce 3 kanały w ramach pasma 2,4 GHz, aby uniknąć sytuacji, w której ten sam kanał jest używany jednocześnie przez sąsiadów. Współczesna technologia Wi-Fi stosuje kanały o szerokości pasma 40 MHz i jest w stanie efektywnie wykorzystać 10 tych kanałów w pasmach 2,4 GHz oraz 5 GHz. Dzięki temu nie tylko może łatwiej odizolować kanał od sąsiednich urządzeń, ale też zoptymalizować zużycie pasma w obrębie domu, oferując różnym użytkownikom różne kanały. Pozwala również wykorzystać rozproszoną infrastrukturę poprzez umieszczenie w domu wielu punktów dostępowych.

Rozproszona sieć Wi-Fi – to wcale nie takie proste

Jeśli obsługa wielu kanałów Wi-Fi wydaje się równie prosta, co przełączanie cyfrowego radia za pomocą przycisku, w rzeczywistości jest to niestety trudniejszy problem. Tanie implementacje Wi-Fi mogą łatwo powodować przecieki między kanałami, szczególnie w przypadku nadawania z wysoką lub maksymalną mocą. Takie przecieki praktycznie czynią sąsiednie kanały bezużytecznymi, drastycznie obniżając całkowitą pojemność.

Kluczowym problemem Wi-Fi jest obecnie zapewnienie dobrej separacji kanałów, aby zapobiec przesłuchom. Tworzenie produktów Wi-Fi nie ogranicza się już do wyboru układu obsługującego Wi-Fi. Teraz istotne są również układy wejściowe – wzmacniacze i filtry umieszczone między układem Wi-Fi a anteną, które mogą dramatycznie wpłynąć na pojemność rozproszonego systemu Wi-Fi.

Wyższe przepustowości mają znaczenie

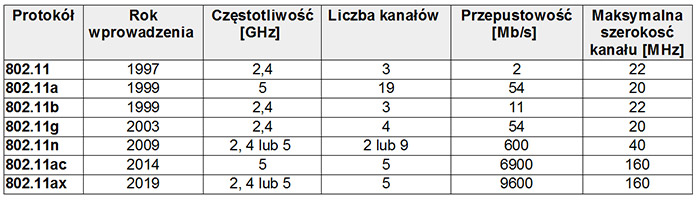

Zapotrzebowanie na coraz wyższe szybkości transferu danych wydaje się być nieograniczone. Spojrzyjmy, jak wyglądała sytuacja wcześniej i jak będzie wyglądać w przyszłości:

Warto zauważyć, że ta tabela opisuje głównie teoretyczną przepustowość. Jednak w praktycznych zastosowaniach występuje z reguły istotna różnica między przepustowością teoretyczną a faktyczną, która często jest niższa o połowę lub nawet więcej. Mając to na uwadze, można zrozumieć, że choć wersja standardu IEEE 802.11ax planowana na rok 2019 oferuje umiarkowany wzrost przepustowości teoretycznej, jej głównym celem jest zwiększenie faktycznie uzyskiwanej przepustowości czterokrotnie w stosunku do IEEE 802.11ac. Ten wzrost pojemności będzie uzyskany poprzez podział kanałów komunikacji na zasadzie MIMO i przypisanie kanałów do różnych użytkowników w celu optymalizacji przepustowości.

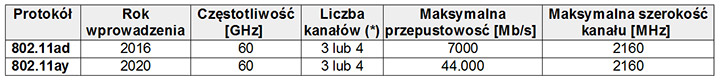

Nowy, lepszy Bluetooth?

Innym przykładem wyścigu o wyższą przepustowość jest rodzina standardów IEEE 802.11 na pasmo 60 GHz (pierwotnie rozwijana przez WiGig, teraz przejęta przez Wi-Fi Alliance). Pierwszy z nich, IEEE 802.11ad, jest już dostępny od ponad roku, ale nie został powszechnie przyjęty. Jest już opracowywana następna generacja standardu, co przedstawia poniższa tabela:

*Liczba kanałów: 3 na terenie Kandy / USA, 4 w Europie

Niestety, częstotliwość 60 GHz ma pewną wadę – nie przenika ścian, a zatem ogranicza zasięg do wnętrza pomieszczenia.

Jednak czy naprawdę stanowi to problem? Jeśli częstotliwość nie wychodzi poza obręb pomieszczenia, nie powoduje interferencji z tym samym kanałem/częstotliwością wykorzystywaną w innym pokoju, a tym bardziej u sąsiadów. To może być całkiem atrakcyjna cecha. Skoro standard 60 GHz 8011.ad istnieje już od dawna, dlaczego nie zdobył zainteresowania na rynku?

Coś tu jest nie tak

Aby zrozumieć ten problem, posłużmy się analogią do systemu drogowego. Istnieją w nim autostrady łączące miasta, drogi główne łączące dzielnice i drogi osiedlowe. Występuje tu hierarchia i ta hierarchia ma sens. Nie ma natomiast autostrad pod oknami ani małych ulic łączących duże miasta. Jednak w przypadku Internetu domowego sytuacja wygląda inaczej.

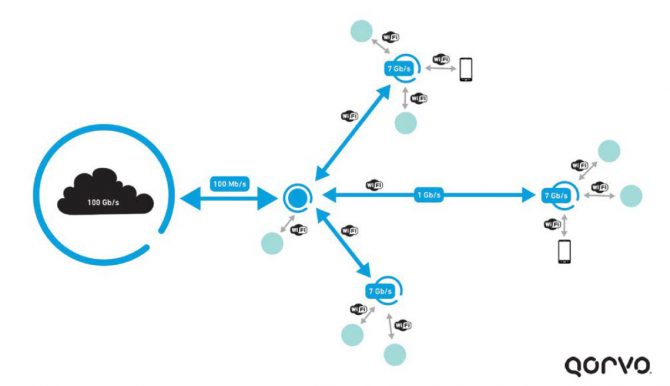

Internet, lub też chmura, cechuje się bardzo wysoką szybkością łączy (100 Gb/s lub więcej) – można je porównać do szerokich autostrad. Jednak droga dojazdowa, docierająca do domu jako sieć dosyłowa (lub też lokalna komórka w przypadku sieci bezprzewodowej) oferuje typową przepustowość 100 Mb/s w najlepszym przypadku – choć pojawiają się już linie światłowodowe 1 Gb/s oraz systemy DOCSIS 3.1 oferujące 10 Gb/s. Dalej następuje wybór opcji rozproszonej sieci Wi-Fi dla domu – na przykład standardu 802.11ac o przepustowości 1 Gb/s lub kabla Ethernetowego 10 Gb/s. Ostatecznie połączenie osiąga węzeł końcowy (telewizor, konsolę do gier, tablet, smartfon), również oferując przepustowość 1 Gb/s, choć w przypadku WiGig (IEEE 802.11d) może to być aż 7 Gb/s.

Coś tu jest nie tak. Gdzie została zachowana hierarchia? Powolne sieci dosyłowe nie są w stanie obsłużyć szybkich sieci domowych. Wewnątrz domu występują autostrady, ale drogę do domu stanowi jedynie mała uliczka. Również wewnątrz domu nie ma prawdziwej hierarchii. Spójrzmy na schemat graficzny:

W takiej sytuacji WiGi wcale nie pomaga

Nie powinno zatem dziwić, że standard WiGi (IEEE 802.11ad) na razie się nie przyjął. Po co budować wielogigabitowe autostrady wewnątrz pokoju, skoro łączą się one z przewodem 1 Gb/s oraz siecią dosyłowa 100 Mb/s? Nie powinno zatem dziwić, że oczekiwania odnośnie przepustowości standardu IEEE 802/11ay rzędu dziesiątek gigabitów są nierealistyczne. Można mieć wyższą przepustowość na łączach z węzłami końcowymi, ale jak zrobić z niej użytek, skoro infrastruktura nie jest w stanie jej obsłużyć?

Z tego powodu różnica między standardami IEEE 802.11ac a IEE 802.11ax polega nie tyle na zwiększeniu całkowitej przepustowości, co raczej na zwiększeniu pojemności sieci domowej – obsłudze wielu użytkowników jednocześnie. Jednak prawdziwą przeszkodą jest przesłanie większej ilości danych do i z domu.

Strumieniowanie i nadawanie ciągłe wpływa na przepustowość

Aby skomplikować sprawę jeszcze bardziej, strumieniowanie i nadawanie ciągłe (burst) również wpływa na pracę sieci. Ponadto istnieje jeszcze jeden czynnik, który dodatkowo komplikuje problem – różnica między strumieniowaniem a nadawaniem ciągłym. Aby strumieniować film, typowo jest potrzebne duże pasmo (np. 20 Mb/s dla wysokiej jakości) dostępne bez przerwy. To wydaje się nietrudne do osiągnięcia w przypadku, gdy do domu dociera łącze o przepustowości 100 Mb/s. Jednak wartość 100 Mb/s ma pewien charakter statystyczny. Jeżeli każdy mieszkaniec ulicy również ogląda film, wartość 100 Mb/s szybko spada do znacznie niższych wartości. Strumieniowanie filmu w sobotni wieczór może być trudne ze względu na wpływ innych mieszkańców ulicy (lub korzystających z tej samej komórki sieci) oglądających film. Jest to sytuacja analogiczna do tej, gdy wszyscy mieszkańcy domu jednocześnie biorą kąpiel – wówczas spada ciśnienie w rurach.

Nadawanie ciągłe to kolejny efekt statystyczny. Można je porównać do próby odkręcenia wszystkich kranów w domu, aby uzyskać maksymalny przepływ wody. Jeżeli ktoś próbuje pobrać film tak szybko, jak to możliwe (w celu np. obejrzenia w późniejszym terminie), powoduje to gwałtowny wzrost wykorzystania przepustowości systemu, który zbliża się na tyle, na ile to możliwe do granicy 100 Mb/s dla jednego domu. Przez krótki czas nie będzie to problemem, jednak nie da się utrzymać tego stanu wiecznie, ponieważ inne punkty w pobliżu zaobserwują pogorszenie przepustowości sieci. Z punktu widzenia statystyki szansa, że każdy mieszkaniec ulicy chciałby pobrać film w tym samym momencie, nie jest wysoka, jednak oczywisty jest fakt, iż szybkie pobieranie ma wpływ na całkowitą dostępną przepustowość.

Co musi się wydarzyć?

Wróćmy teraz do problemu zaburzonej hierarchii. Co trzeba zrobić, aby przywrócić równowagę? Dopóki ten problem nie zostanie rozwiązany, bardzo trudno będzie usprawiedliwić wzrost przepustowości wewnątrz domu. Przyjrzyjmy się zatem bliżej warunkom użytkowania: ile osób mieszka w domu, ile ma on pokoi lub pięter, ile urządzeń wykorzystuje jednocześnie użytkownik itp.

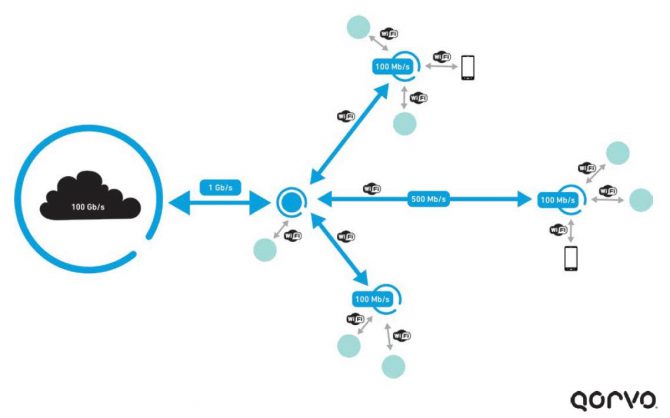

Wyobraźmy sobie czteroosobową rodzinę. W jednym pokoju gra radio internetowe, mama odbywa konferencję wideo w jednym pokoju, tata pobiera duży raport na swój komputer, syn gra w grę wideo, a córka ogląda YouTube na swoim telefonie. Ponadto w tym czasie telewizor odtwarza strumieniowany film. Ta rodzina bardzo ucieszyłaby się z łącza dosyłowego 1 Gb/s, domowego systemu dystrybucji o przepustowości 500 Mb/s oraz punktów dostępowych oferujących 100 Mb/s dla urządzeń, co widać na obrazku poniżej.

Obecnie wyzwanie stanowi dostarczenie do domu łącza 1 Gb/s. Choć rozpoczęły się już wdrożenia systemu DOCSIC 3.1 oferującego 10 Gb/s, większość ludzi nadal ma dostęp do sieci 100 Mb/s lub wolniejszej. To oznacza, że obecnie występuje znaczna nadwyżka pojemności sieci wewnątrz budynku oraz w węzłach końcowych, które dysponują przepustowością ponad 1 Gb/s.

Caroline Pannier – nowa dyrektorka targów electronica – analizuje sytuację gospodarczą branży i przedstawia wyniki

Caroline Pannier – nowa dyrektorka targów electronica – analizuje sytuację gospodarczą branży i przedstawia wyniki  Konstrukcja Ventiva Zoned Cooling™ – ukierunkowane chłodzenie powietrza dla urządzeń AI Edge

Konstrukcja Ventiva Zoned Cooling™ – ukierunkowane chłodzenie powietrza dla urządzeń AI Edge  Komunikacja dalekiego zasięgu oparta na technologii Qualcomm dla robotyki i dronów

Komunikacja dalekiego zasięgu oparta na technologii Qualcomm dla robotyki i dronów