Raspberry Pi kluczem do przemysłowych centrów danych

Przemysł 4.0 to trend, który niesie ze sobą istotne konsekwencje dla architektury przemysłowych systemów obliczeniowych. Kluczowym kierunkiem w Przemyśle 4.0 jest połączenie technologii informatycznej (IT – Information Technology) z operacyjną (OT – Operational Technology), która odpowiada za nadzorowanie prac maszyn i sterowanie procesami w zakładach fabrycznych. Wzmożona komunikacja pomiędzy tymi dwiema częściami biznesu produkcyjnego sprawia, że dostawcy mogą znacznie szybciej reagować na zmiany na rynku. Drugim czynnikiem napędzającym Przemysł 4.0 jest wykorzystanie integracji IT z OT do sterowania procesami w zakładach przemysłowych, które jest w większym stopniu oparte o przetwarzanie danych.

Zamiast tworzyć linie produkcyjne, w których surowce i półprodukty przechodzą przez szereg z góry określonych etapów, podczas których powstaje gotowy produkt, ścieżka przemieszczania komponentów jest określana w czasie rzeczywistym, w oparciu o wymagania stawiane w danej chwili przed produktem i bazując na aktualnej dostępności poszczególnych urządzeń. Dwa warianty produktu mogą być przetwarzane przez różne maszyny lub grupy maszyn, w zależności od tego jakie komponenty są potrzebne i jak mają być wykończone. Założenie polega na tym, że każdy gotowy produkt wychodzący z fabryki można dostosować do specyficznych wymagań nabywcy. Takie masowe dostosowanie produktów do indywidualnych wymagań to sposób na zwiększenie zysków i zdobycie większej części rynku przez firmy, które wdrożą to podejście.

Elastyczność kluczem do Przemysłu 4.0

Elastyczność to krytycznie ważny czynnik, odnoszący się tak samo do infrastruktury obliczeniowej, nadzorującej zakład fabryczny, jak i do oprzyrządowania oraz systemów przekierowujących prace do różnych sektorów fabryki. Dawniej koncentrowano się na samodzielnych, niezależnych grupach maszyn i robotach, realizujących z góry ustalone zadania. Systemy Przemysłu 4.0 wymagają znacznie większej koordynacji, nie tylko na terenie zakładu, ale i w systemach biurowych, które planują i wysyłają zamówienia. Jednocześnie szybsze sieci, niezbędne do zapewnienia omawianej integracji IT-OT, mogą być używane do rozbudowania zestawu funkcji realizowanych przez maszyny i roboty znajdujące się już w fabryce.

W takim środowisku możliwe jest uruchamianie zadań, które wymagają większej mocy obliczeniowej. Dodatkowo nie wymaga to znaczących inwestycji na rozbudowę komputerów przemysłowych i systemów sterowania. Za przykład może posłużyć wspomagane przez sztuczną inteligencję narzędzie do inspekcji wizualnej. Ma ono na celu sprawdzanie jakości montowanych produktów lub nakładanych pokryć. Zadanie może być przekazane do elastycznie pracujących komputerów – szczególnie wtedy gdy czas reakcji ma duże znaczenie. Jeśli natomiast lokalnie dostępna moc obliczeniowa jest niewystarczająca, zadanie może być przekazane do aplikacji pracującej w chmurze. Wtedy lokalne systemy obliczeniowe będą jedynie kompresować obrazy i materiały wideo by zminimalizować czas i koszt transferu danych.

Systemy mogą w czasie rzeczywistym wskazywać najlepsze podejście, by odpowiednio zrównoważyć zużycie lokalnych zasobów i zoptymalizować czas reakcji. Jeśli przykładowo lokalny, względnie prosty model sztucznej inteligencji wykryje wadę nałożonego pokrycia, dane mogą zostać przekazane do chmury. Można tak dokonać bardziej zaawansowanej analizy, która pozwoli zdecydować, czy problem leży w maszynie, czy w surowcach.

Przetwarzanie sieciowe pozwala na poprawienie jakości produktów

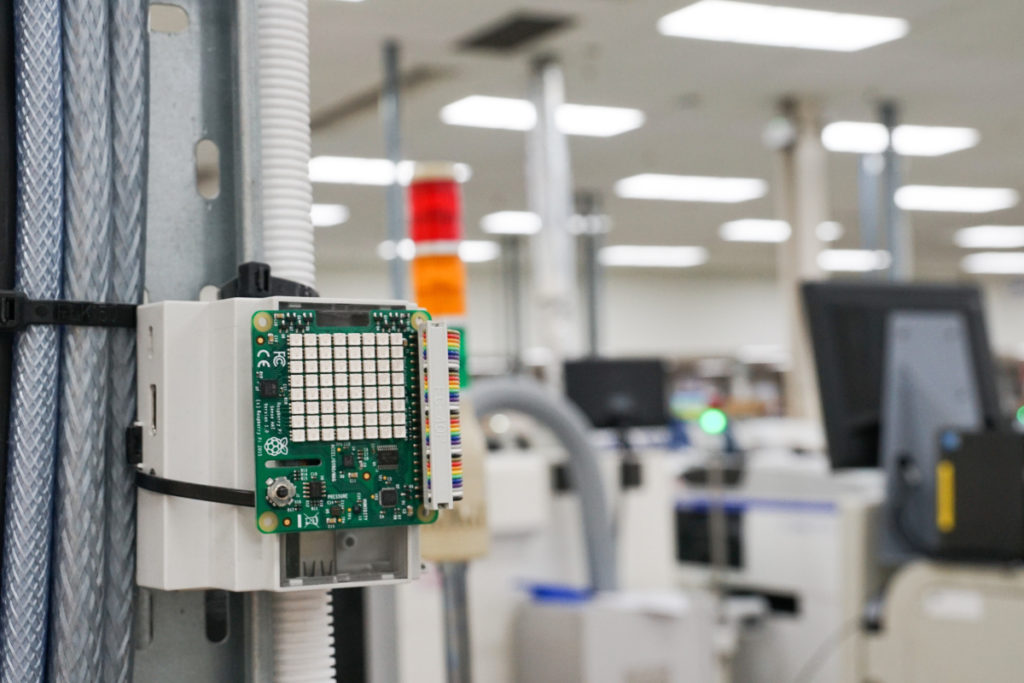

Dzięki przetwarzaniu sieciowemu łatwiej jest rozszerzać zespoły produkcyjne, wzbogacając je o dodatkowe czujniki i algorytmy, które pozwolą poprawić ogólną jakość wyrobów. Przykładowo, zmiany temperatury i wilgotności mogą wpłynąć na występujące procesy chemiczne. Ma to bezpośrednie przełożenie na jakość farby czy trwałość jej trzymania się pomalowanej powierzchni. Zamiast wymieniać maszyny na takie, które mają wbudowane czujniki, zakłady wdrażające Przemysł 4.0 nierzadko decydują się na dołączenie interfejsów czujnikowych do modułów komputerowych, które przetwarzają dane do postaci używanej przez starsze maszyny. Takie właśnie podejście w swoim zakładzie zastosował brytyjski producent rowerów – firma Brompton. Firma wykorzystała moduły Raspberry Pi, by rozszerzyć możliwości śledzenia produktów w fabryce bez konieczności wymiany kluczowych urządzeń. Zakład używa teraz ponad 100 niedrogich modułów Raspberry Pi. Znajdują się one wszędzie tam, gdzie potrzebne są dodatkowe pomiary i zbieranie danych za pomocą czujników.

W Singapurze firma Jabil świadcząca usługi produkcji elektroniki wdrożyła komputery Raspberry Pi jako swoją kluczową platformę sprzętową. Program cyfryzacji fabryki pozwolił na łatwe tworzenie aplikacji, testowanie ich i bezpieczne wdrażanie na produkcję, niezależnie gdzie ona jest prowadzona. Wspólnym mianownikiem tych działań jest realne zastosowanie komputera Raspberry Pi. Jedną z zalet jest wysoka kompatybilność pomiędzy poszczególnymi wersjami sprzętu i utrzymanie najważniejszych cech użytkowych. W efekcie znacznie łatwiej jest przenosić aplikacje do miejsc, gdzie są akurat potrzebne.

Integracja oprogramowania i sprzętu

Raspberry Pi ma też ważne zalety z punktu widzenia kolejnego etapu wdrażania Przemysłu 4.0. Sieci niedrogich, zintegrowanych komputerów pozwalają utworzyć rozproszone centrum danych zakładu, w którym aplikacje można przenosić tam, gdzie są potrzebne. W takim środowisku narzędzia programowe i komponenty, opracowane na potrzeby centrów danych w chmurze można przystosować do pracy w na krawędzi sieci.

Bazując na rodzinie mikroprocesorów z rdzeniami ARM Cortex-A, każdy komputer Raspberry Pi jest wielordzeniowy. Dysponuje też mechanizmami zarządzania pamięcią, które pozwalają na uruchamianie takich systemów operacyjnych jak Linux. Systemy te opierają się m.in. na wykorzystaniu pamięci wirtualnej. Dysponują także szybkimi portami wejść i wyjść. Ponadto można je zasilać za pomocą wygodnego złącza USB. Przykładowo, Raspberry Pi 4 zawiera czterordzeniowy układ SoC marki Broadcom. Procesor wyposażono m.in. w 1 MB pamięci cache L2, dwa wyjścia HDMI wideo do prezentowania interfejsu oraz gigabitowy Ethernet.

W Raspberry Pi wsparcie dla Linuksa jest natywne. Jest to niezbędny czynnik, pozwalający klientom przemysłowym na skorzystanie z zalet rozwijania i wdrażania oprogramowania w oparciu o technologie chmur obliczeniowych. Kluczowymi elementami dzisiejszych systemów chmurowych są wirtualizacja i konteneryzacja. Wirtualizacja zapewnia efektywniejsze oddzielenie od siebie aplikacji, niż przy uruchamianiu na tym samym systemie operacyjnym.

W ramach wirtualizacji aplikacje działające w jednym systemie operacyjnym nie mogą uzyskać dostępu do pamięci aplikacji działających w innym. Cały dostęp do interfejsów lub pamięci, wykraczający poza własną wirtualną przestrzeń adresową, jest przechwytywany przez tzw. hypervisor. Jest to bardzo korzystne z punktu widzenia systemów przemysłowych, w których aplikacje kluczowe przy realizacji podstawowych funkcji maszyny muszą jednocześnie pracować wraz z programami firm trzecich, realizującymi dodatkowe funkcje. Jeśli któraś z tych części będzie wymagała aktualizacji, odbędzie się ona niezależnie od pozostałych, bez wpływania na inne komponenty programowe. Co więcej, wsparcie dla mechanizmu Trustzone zapewnia sposoby pozwalające na sprawdzenie autentyczności wgrywanych obrazów programów zanim jeszcze zostaną one zainstalowane. Daje też możliwość kontrolowania ich dostępu do wejść i wyjść w momencie uruchamiania programów.

Potęga konteneryzacji i orkiestracji

Wirtualizacja narzuca pewne dodatkowe obciążenie na procesor, gdyż musi on przechwytywać żądania dostępu do pamięci oraz wejść i wyjść. W odpowiedzi na ten problem branża opracowała rozwiązanie bardziej wydajne z punktu widzenia wykorzystania zasobów – konteneryzację. Istnieje wiele funkcji bezpieczeństwa wbudowanych bezpośrednio w system Linux. Można go użyć do uniemożliwienia aplikacjom wpływania na zawartość pamięci poza ich własną przestrzenią adresową. Jednocześnie nie nakładają dodatkowego obciążenia typowego dla hypervisora. Drugą z ważnych zalet technologii konteneryzacji jak Kata czy Docker jest możliwość pakowania wszystkich bibliotek i funkcji systemowych, jakich wymaga dana aplikacja tak, by całość znajdowała się w postaci jednego obrazu. Z łatwością można go przenieść na dowolne, kompatybilne urządzenie w sieci. Kontener izoluje aplikację od sprzętu i od różnic systemowo-programowych. Dzięki temu mamy pewność, że stworzona aplikacja poprawnie działa w dowolnym miejscu udostępniającym moc obliczeniową.

W chmurze korzysta się z bezpłatnego, opracowanego przez firmę Google i oferowanego z otwartym kodem źródłowym narzędzia Kubernetes. Pozwala ono na orkiestrację, czyli ładowanie, uruchamianie, przenoszenie i usuwanie kontenerów w sposób automatyczny, oparty o wcześniej ustalone zasady. Podobne narzędzia wkraczają teraz do świata przemysłowego przetwarzania na krawędzi sieci dzięki takim programom jak Project Cassini firmy ARM. Połączenie konteneryzacji i orkiestracji zapewnia użytkownikom przemysłowym maksymalizację wykorzystania systemów komputerowych i czyni je odpornymi na to co przyniesie przyszłość. Infrastrukturę taką można z łatwością rozbudowywać poprzez dodawanie nowych lub ulepszanie istniejących modułów procesorowych. Platforma Raspberry Pi natomiast pozwala na realizację tej idei w efektywny kosztowo sposób oraz na skorzystanie z wbudowanych interfejsów. Te ostatnie zapewniają możliwość wzajemnej komunikacji wszystkim systemom, zlokalizowanym w takich rozproszonych centrach danych.

W efekcie, Raspberry Pi to znacznie więcej niż tylko niedroga platforma do szybkiego przetwarzania danych. Dzięki migracji technologii chmurowych w przestrzeń produkcyjną, komputery te mogą stanowić podstawę przemysłowych centrów danych, niezbędnych do połączenia IT z OT pod parasolem Przemysłu 4.0.

Czy potężny rozbłysk słoneczny zagraża Ziemi? [opinia eksperta IŁ]

Czy potężny rozbłysk słoneczny zagraża Ziemi? [opinia eksperta IŁ]  Świetlana przyszłość przemysłu elektronicznego według Dave Doherty, prezesa zarządu DigiKey

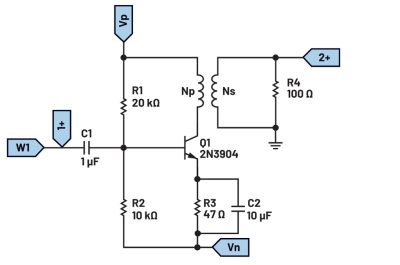

Świetlana przyszłość przemysłu elektronicznego według Dave Doherty, prezesa zarządu DigiKey  Zastosowanie zestawu ADALM2000 do pomiarów wzmacniacza sprzężonego transformatorowo

Zastosowanie zestawu ADALM2000 do pomiarów wzmacniacza sprzężonego transformatorowo