Elastyczne wykorzystanie sztucznej inteligencji na obrzeżach sieci

Niewiele będzie w przyszłości obszarów, które pozostaną nietknięte przez AI. Oprócz zastosowań na poziomie przedsiębiorstw, pojawia się wiele aplikacji do uczenia maszynowego oraz sztucznej inteligencji dla komputerów brzegowych i urządzeń internetu rzeczy (IoT), często w połączeniu z przetwarzaniem sygnałów i obrazów. Bezpieczeństwo i ochrona są tutaj motorem wielu aplikacji.

Technologia ta umożliwia wykrywanie intruzów, a w szerszej perspektywie również anomalii w ruchach tłumu, które mogą sygnalizować sytuacje wymagające interwencji człowieka.

Christian Bauer

Inne zastosowania to sektory kontroli przemysłowej czy rolnictwa, gdzie jeden lub więcej modeli AI pobiera informacje z wielu czujników i łączy je w jeden spójny model. W ten sposób może wykrywać wzorce. Oczywiście są komponenty, które mogą zawieść i w ten sposób utrudnią stosowanie modeli deterministycznych do oceny stanu obrabiarki. Z drugiej jednak strony, przy szkolenie modelu uczenia maszynowego wykorzystywane są rzeczywiste dane do oceny, kiedy i z jakiego powodu narzędzie będzie wymagało konserwacji.

Sztuczna inteligencja zapewnia środki do poprawy kontroli jakości w produkcji i w usługach użyteczności publicznej, takich jak chociażby zaopatrzenie w wodę. Model przeszkolony w zakresie oczekiwanych przepływów i anomalii może wykazać, kiedy jakość wody wykracza poza tolerancję, jeszcze na długo przed jej pogorszeniem się do punktu, w którym części i podsystemy muszą zostać wymienione.

Połączenie sztucznej inteligencji z przetwarzaniem sygnałów stwarza możliwości w zakresie sieci i komunikacji. Uczenie maszynowe i sztuczna inteligencja mogą wykorzystywać dane szkoleniowe do optymalizacji warunków przesyłu danych i podejmowania świadomych, minimalizujących przeciążenia, decyzji dotyczących routingu.

Oprócz zastosowań opartych na czujnikach, sztuczna inteligencja zapewnia możliwość radykalnego ulepszenia interfejsu użytkownika za pomocą sterowania głosem lub gestami rąk. W środowiskach, w których ważna jest obsługa bez użycia palców, funkcje te mogą poprawić bezpieczeństwo, higienę i wydajność.

Nie ma jednego rozwiązania dla wszystkich

Istnieje tak wiele zastosowań, że nie ma jednego rozwiązania AI, które pasowałoby do wszystkich. Każdy przypadek użycia będzie wymagał modelu, który ma najlepszy zestaw funkcji do jego obsługi. Sterowanie głosowe i gestami skorzysta z tej samej technologii modelu językowego, która obecnie stanowi podstawę generatywnej sztucznej inteligencji. Aplikacje zorientowane na czujniki będą częściej opierać się na architekturach konwolucyjnych sieci neuronowych (CNN). Niektóre z nich mogą jednak skorzystać z dodatkowej funkcjonalności oferowanej przez implementacje oparte na transformatorach wizyjnych, choć kosztem wyższej wydajności.

Sztuczna inteligencja potrzebuje zwiększonej wydajności

Przed pojawieniem się generatywnej AI rocznie wzrastała ona trzykrotnie. Modele na transformatorach zwiększyły ten wzrost ponad dziesięć razy w skali roku.

Sztuczna inteligencja oparta na serwerach zapewnia dostęp do modeli o najwyższej wydajności. Jednak w wielu zastosowaniach wbudowanych i przemysłowych dostęp do tych systemów nie jest idealny. Operatorzy i użytkownicy chcą bezpieczeństwa swoich danych, a w wielu przypadkach połączenia sieciowe w terenie nie są wystarczająco niezawodne, aby obsługiwać sztuczną inteligencję opartą na chmurze.

Użytkownicy potrzebują możliwości uruchamiania modeli sztucznej inteligencji na urządzeniach. Możliwość ta wynika częściowo z zastosowania wbudowanych procesorów o wyższej wydajności, zoptymalizowanych pod kątem docelowego środowiska. Zapewniają one większą prywatność danych i mniejsze opóźnienia. Ponadto, ponieważ sztuczna inteligencja brzegowa nie wymaga niezawodnego połączenia z Internetem, doskonale sprawdza się w takich środowiskach. Kolejnym czynnikiem sprzyjającym sztucznej inteligencji na urządzeniach jest sposób, w jaki eksperci w tej dziedzinie dostosowali modele oparte na serwerach, aby działały wydajniej w systemach wbudowanych.

ResNet i Mobilenet

Naukowcy opracowali architektury CNN, takie jak ResNet i Mobilenet, aby zapewnić wysoką dokładność rozpoznawania obrazów przy użyciu mniejszej liczby mnożeń macierzy niż w poprzednich modelach do wdrożenia na serwerach. Architektury nowych modeli dzielą wymagające dużych nakładów obliczeniowych filtry na mniejsze dwuwymiarowe sploty. Wykorzystali również takie techniki, jak łączenie warstw, w których kolejne operacje kierują dane przez obliczenia wagowe i operacje aktywacyjne więcej niż jednej warstwy. Techniki te wykorzystują lokalność danych, aby uniknąć dostępu do pamięci zewnętrznej, który jest kosztowny pod względem energii i opóźnień.

Projektanci połączyli te i inne architektury modeli, zoptymalizowane pod kątem brzegów sieci, z technikami takimi jak przycinanie i kwantyzacja. Przycinanie zmniejsza ogólną liczbę operacji potrzebnych do przetworzenia każdej warstwy. Często jednak nie pasuje ono do wysoce zoptymalizowanych silników mnożenia macierzy opracowanych do przetwarzania neuronowego. W praktyce zastosowanie kwantyzacji zapewnia lepsze wyniki przy niższych kosztach, wykorzystując silniki arytmetyczne SIMD (single-instruction multiple-data), zaprojektowane do operacji macierzowych i wektorowych.

Zastosowanie arytmetyki 8-bitowej, a nawet mniejszej szerokości słów, zamiast znacznie dłuższych formatów zmiennoprzecinkowych, używanych podczas szkolenia modelu, skutkuje ogromnym zmniejszeniem zapotrzebowania na moc obliczeniową i energię. Ponieważ możliwe jest równoległe wykorzystanie wielu 8-bitowych silników arytmetycznych zamiast pojedynczej jednostki zmiennoprzecinkowej o wysokiej precyzji, procesor wbudowany może zapewnić znaczną poprawę przepustowości przy tych samych kosztach energii i matrycy.

Odkrywanie architektury Qualcomm

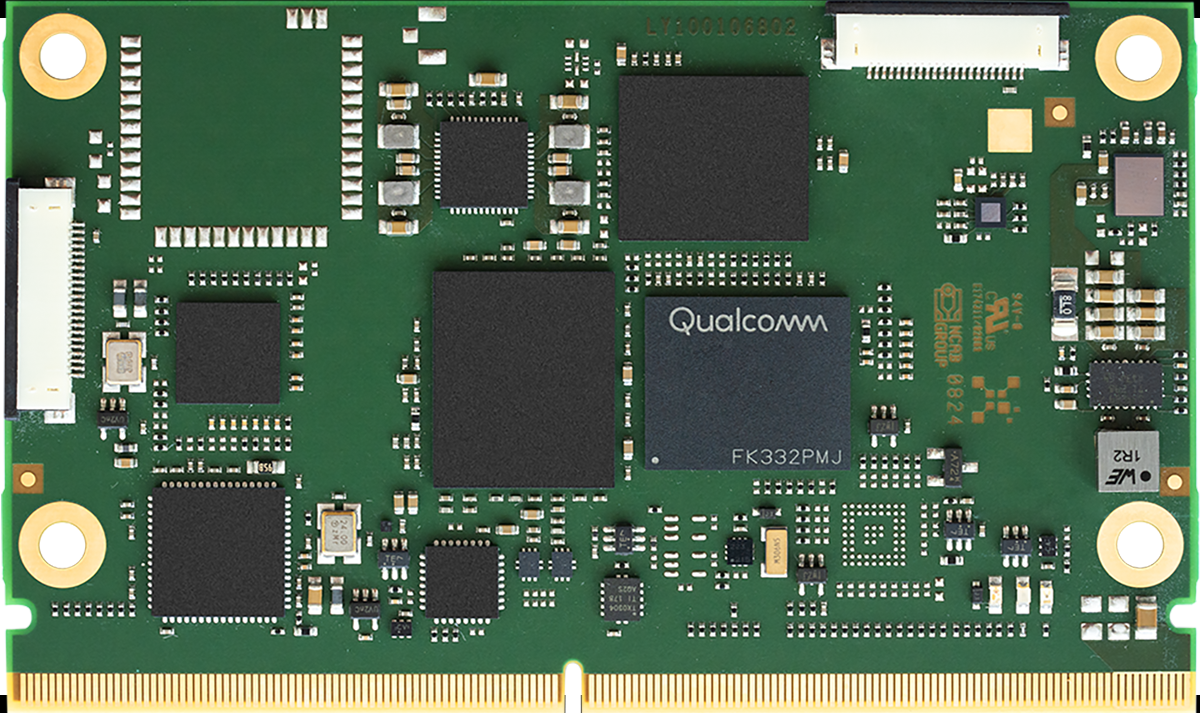

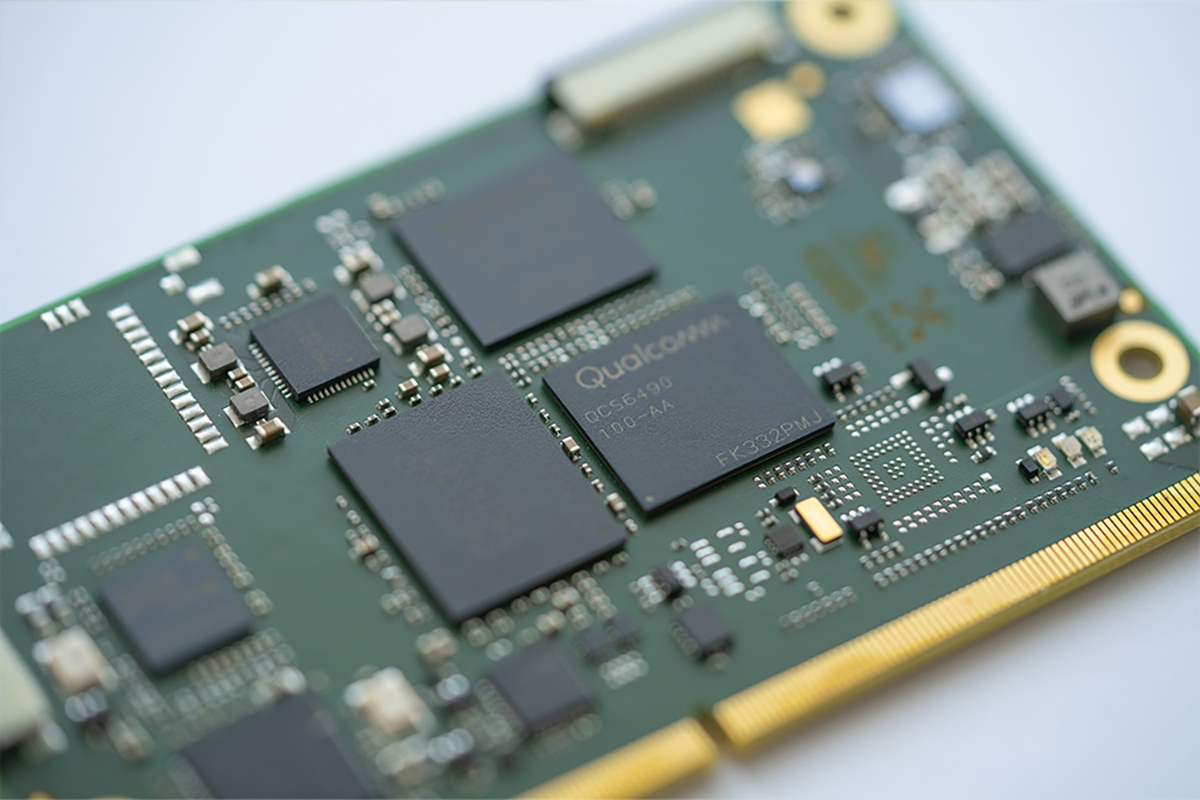

Procesor neuronowy Hexagon (NPU) firmy Qualcomm wykorzystał te techniki w serii układów SoC (System-on-Chips) Snapdragon przeznaczonych do telefonów komórkowych. Dzięki temu układy SoC obsługują takie funkcje, jak rozpoznawanie twarzy i mowy. Ten sam procesor jest obecnie dostępny dla użytkowników przemysłowych w serii układów SoC Dragonwing, gdzie towarzyszą mu rdzenie aplikacyjne serii Cortex-A oparte na architekturze Arm oraz procesor graficzny (GPU) Adreno.

Obecne generacje procesorów Hexagon odzwierciedlają długoterminowe zaangażowanie w przetwarzanie sygnałów, uczenie maszynowe i zadania związane ze sztuczną inteligencją.

Pierwsza wersja procesora Hexagon pojawiła się w 2007 roku i początkowo obsługiwała zadania związane z cyfrowym przetwarzaniem sygnałów (DSP) za pomocą silnika skalarowego opartego na architekturze VLIW (Very Long Instruction Word), zapewniającej wysoką przepustowość danych. Kluczową innowacją, która sięga czasów tej implementacji, jest symetryczna wielowątkowość (SMT). Wykorzystując równoległość na poziomie wątków, architektura ukrywa wiele problemów spowodowanych opóźnieniami pamięci zewnętrznej. Ta filozofia projektowania została przeniesiona na kolejne generacje Hexagon, wraz z naciskiem na stworzenie ujednoliconej architektury, która pozwala programistom w pełni wykorzystać zasoby sprzętowe Hexagon.

Połączenie silników skalarnych, wektorowych i tensorowych

Późniejsze generacje procesora Hexagon NPU dodały obsługę równoległej arytmetyki wektorowej, a następnie wielowymiarowych tensorów, w połączeniu z pełnym procesorem skalarnym, który może uruchamiać system Linux bez konieczności korzystania z pomocy procesorów Arm w układzie SoC, jeśli aplikacja tego wymaga. Połączenie silników skalarnych, wektorowych i tensorowych, które mają wspólny dostęp do pamięci centralnej, zapewnia ową wysoką elastyczność.

NPU jest również wyposażony w funkcję wnioskowania mikro-kafelkowego, technikę, która umożliwia wydajną obsługę mniejszych modeli AI, gdy zastosowanie wymaga bardzo niskiego zużycia energii. Dzięki temu prosty model może działać przez długi czas w stanie niskiego zużycia energii, wykrywając określone rodzaje dźwięków, takie jak ludzki głos. Wiele mikro-kafelków może funkcjonować jednocześnie, dzięki czemu model ten nadal działa, podczas gdy inne zajmują się rozpoznawaniem mowy. Architektura wspólnej pamięci pozwala programistom w pełni wykorzystać takie techniki, jak łączenie warstw. Technika ta pozwala połączyć dziesięć lub więcej warstw, eliminując potrzebę zapisywania wyników pośrednich w pamięci zewnętrznej.

Zaangażowanie Qualcomm w rynek AI: edge i embedded

Niedawna oferta Qualcomm dotycząca przejęcia Edge Impulse sygnalizuje dalsze zaangażowanie w rynek sztucznej inteligencji brzegowej i wbudowanej. Wraz z wprowadzeniem na rynek układów SoC z serii Dragonwing, które wykorzystują różne wersje rdzeni Hexagon, Adreno i Cortex-A w celu zaspokojenia różnych wymagań dotyczących wydajności.

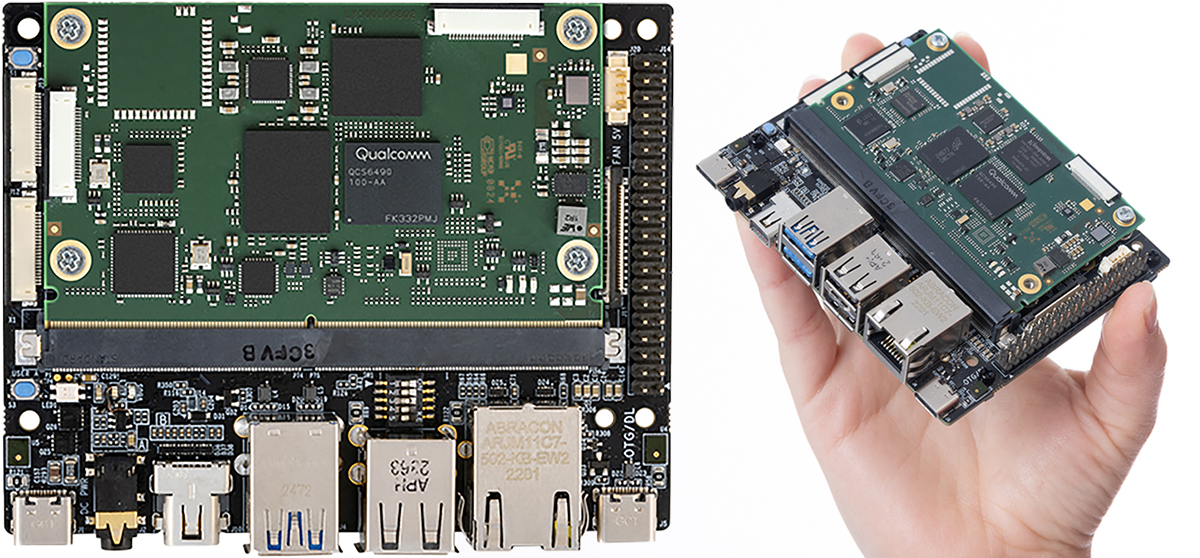

Rozpoznając potrzebę dostępu do różnych modeli, centrum AI firmy Qualcomm zapewnia użytkownikom setki różnych implementacji modeli, z których każda jest zoptymalizowana pod kątem platform Snapdragon i Dragonwing. Muszą oni jedynie wybrać i pobrać modele, aby rozpocząć pracę z AI, co pozwala im wypróbować różne podejścia i sprawdzić, które najlepiej pasuje do docelowej aplikacji. Dodatkową pomocą w szybkim prototypowaniu i rozwoju jest dostępność sprzętu typu compute-on-module opartego na otwartym standardzie SMARC.

Partnerstwo firmy Tria z Qualcomm

Zapewnia możliwość dostosowania modułów opartych na tym standardzie, a jednocześnie skraca czas wprowadzenia produktu na rynek i zwiększa skalowalność pod względem procesora i pamięci. Procesory dostępne obecnie w tym formacie to QCS5490 i QCS6490, a także większy Vision AI-KIT. Zoptymalizowany pod kątem wysokowydajnego przetwarzania wideo procesor IQ9075 w zestawie Vision AI-KIT może zapewnić wydajność na poziomie 100 TOP (tera operacji na sekundę).

Wraz z rozprzestrzenianiem się sztucznej inteligencji w aplikacjach brzegowych i wbudowanych, programiści potrzebują łatwego dostępu do jak najszerszej gamy modeli i punktów wydajności, aby sprostać oczekiwaniom w zakresie kosztów i usług. Dostępność akceleratorów sztucznej inteligencji Qualcomm Dragonwing w modułach, w połączeniu z obszerną biblioteką modeli i oprogramowaniem pomocniczym, pomoże tej ekspansji nabrać jeszcze większego tempa.

Tria rozszerza portfolio SMARC o nowy moduł oparty na procesorze Renesas RZ/G3E do zastosowań HMI

Tria rozszerza portfolio SMARC o nowy moduł oparty na procesorze Renesas RZ/G3E do zastosowań HMI  Qualcomm przejmuje Arduino. Przyspieszy dostęp programistów do rozwiązań w zakresie przetwarzania danych oraz AI

Qualcomm przejmuje Arduino. Przyspieszy dostęp programistów do rozwiązań w zakresie przetwarzania danych oraz AI  Tria Technologies wprowadza na rynek pięć nowych rodzin produktów opartych na platformach Qualcomm Dragonwing™ i Snapdragon®

Tria Technologies wprowadza na rynek pięć nowych rodzin produktów opartych na platformach Qualcomm Dragonwing™ i Snapdragon®